Docker 安装 Magnetboard 一款基于色花堂的爬虫AV订阅下载

前言

CAUTION更新:作者已经决定收费,本文章不再更新,目前也没有开源。

这是一个新的AV下载项目,和之前的MDC有所区别,这个是很多资源是通过98堂进行下载的。相比馒头来说可以更快的获取中文和无码的AV版本。整个项目基于AI开发,是作者的小玩具。项目是伪开源,根据作者的说法是如果需要可以提供源码。整个项目的逻辑应该是相当于爬下色花堂的帖子和信息历史,存到自己的本地数据库来搜索。然后提供推送到qb等功能,因此该项目应该会对色花堂网站造成不小的负担。

CAUTION不建议在本项目启用emby库之类的操作,尤其在你已经有了一定数量的库。强烈注意要隔离,由于 Vibe Coding 的特殊性,不要随便主库尝试。我的建议是仅仅当作一个辅助下载来用。

Dockerhub仓库: hub.docker.com

作者的文档:Magnetboard 完整使用指南

项目特色

- 可视化番号库管理 - 直观的界面管理你的磁力链接

- 智能搜索筛选 - 快速找到你需要的内容

- 批量操作 - 支持批量复制和推送磁力链接

- 多下载器支持 - 兼容 qBittorrent 等主流下载器

- 115 网盘集成 - 支持离线下载功能

- 自动化推送 - 定时任务和自动推送功能

- Telegram 机器人 - 远程控制和通知功能

搭建

相信常看我博客的都知道docker了,以后也不会在过多描述这部分的初始化了。你要做的就是创建个文件夹在里面写 docker-compose.yaml.

容器镜像体积不小,接近1G,建议国内pull的时候使用镜像源。不建议直接暴露数据库端口到公网,内网随意。

version: '3.8'

services: sehuatang-crawler: image: wyh3210277395/magnetboard:latest container_name: sehuatang-crawler ports: - "8000:8000" # 仅暴露 Web 界面 environment: # ----------------------------- # 数据库配置(内部连接) # ----------------------------- - DATABASE_HOST=postgres - DATABASE_PORT=5432 - DATABASE_NAME=sehuatang_db - DATABASE_USER=postgres - DATABASE_PASSWORD=postgres123

# ----------------------------- # 应用配置 # ----------------------------- - PYTHONPATH=/app/backend - ENVIRONMENT=production - ADMIN_PASSWORD=admin123

# ----------------------------- # 代理配置(可选) # ----------------------------- - HTTP_PROXY=http://your-proxy:port - HTTPS_PROXY=http://your-proxy:port - NO_PROXY=localhost,127.0.0.1,192.168.0.0/16,10.0.0.0/8,172.16.0.0/12

# ----------------------------- # Telegram 机器人配置(可选) # ----------------------------- - TELEGRAM_BOT_TOKEN=你的Bot_Token - TELEGRAM_BOT_WEBHOOK_URL= - TELEGRAM_BOT_WEBHOOK_SECRET=

# ----------------------------- # CloudDrive2 配置(可选) # ----------------------------- - CLOUDDRIVE_HOST=你的CD2主机地址 - CLOUDDRIVE_PORT=你的CD2端口

volumes: - sehuatang_data:/app/data - sehuatang_logs:/app/logs

depends_on: - postgres

restart: unless-stopped

postgres: image: postgres:15-alpine container_name: sehuatang-postgres environment: - POSTGRES_DB=sehuatang_db - POSTGRES_USER=postgres - POSTGRES_PASSWORD=postgres123 volumes: - postgres_data:/var/lib/postgresql/data restart: unless-stopped

volumes: sehuatang_data: sehuatang_logs: postgres_data:

networks: default: name: sehuatang-network首次启动时间:约 10–60 秒(取决于镜像拉取与数据库初始化速度)。

访问地址:http://<你的IP或域名><8000>

接口文档:http://<你的IP或域名><8000>/docs

如果你的反向代理占用了 8000 端口,修改 ports: “8000<8000>” 的左侧为其它端口即可(例如 18000<8000>)。

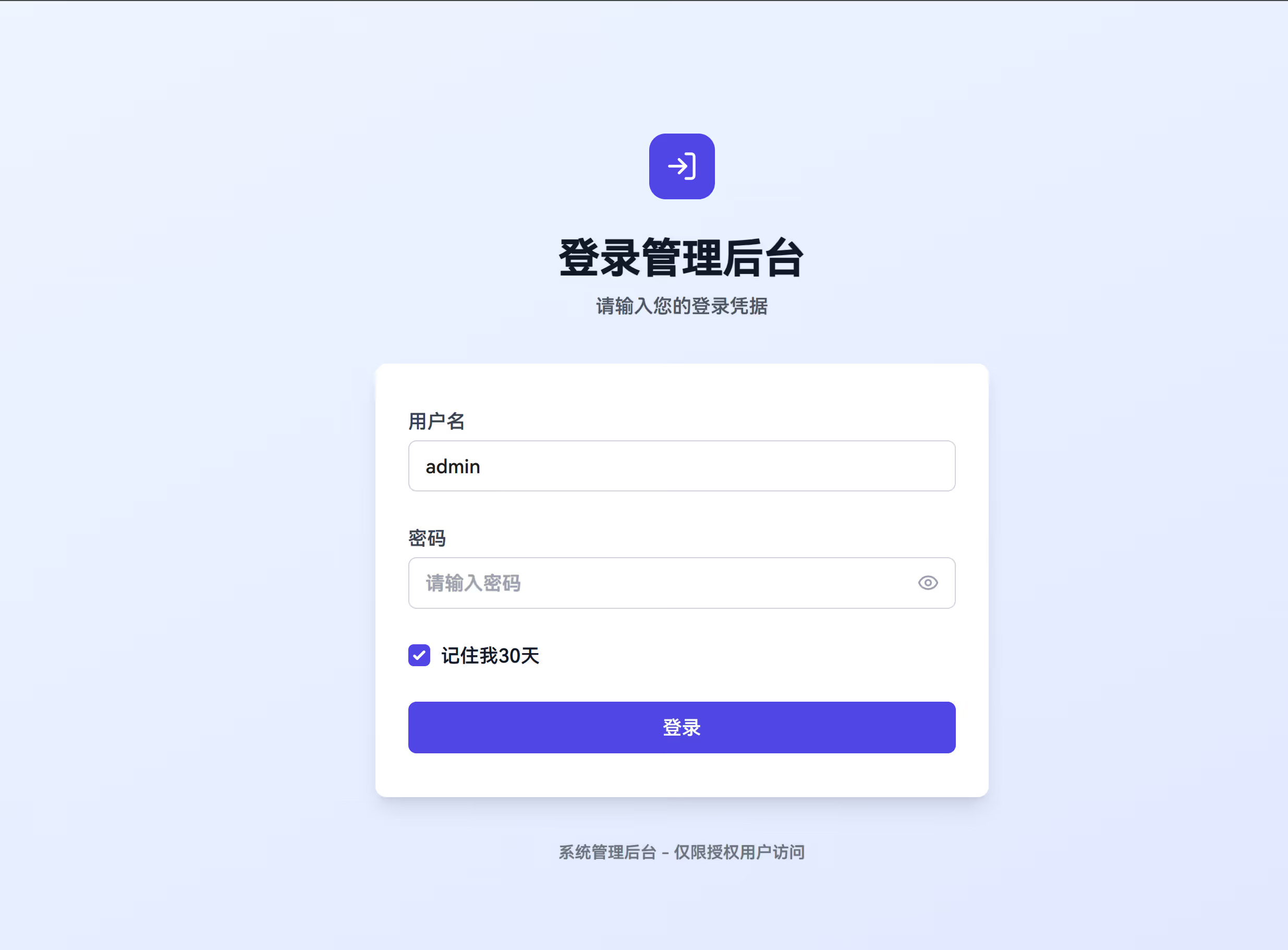

登录

默认账户名为 admin,密码是你在 docker-compose.yaml 设置的。

这里下载器怎么QB连接和TG通知我也不再过多赘述了,输入你的就行。

为了第一次安全起见,我的建议是重新新开一个qb用于这个模块。以免未知bug造成qb的其他资源删除。

新建爬虫

用于创建「普通爬虫任务」(无需 Cookie)。创建后可在【定时任务】里设置计划,在【数据总览】查看抓取结果。

我也没色花堂的账户,那些自动签到等的功能我就不演示了。

示例 1:按页抓取

• 任务名称:SONE无码破解

• 板块分类:亚洲无码

• 起始页:1;结束页:100

• 立即执行:开

结果:保存后立即抓取 1–100 页,内容出现在【数据总览】。

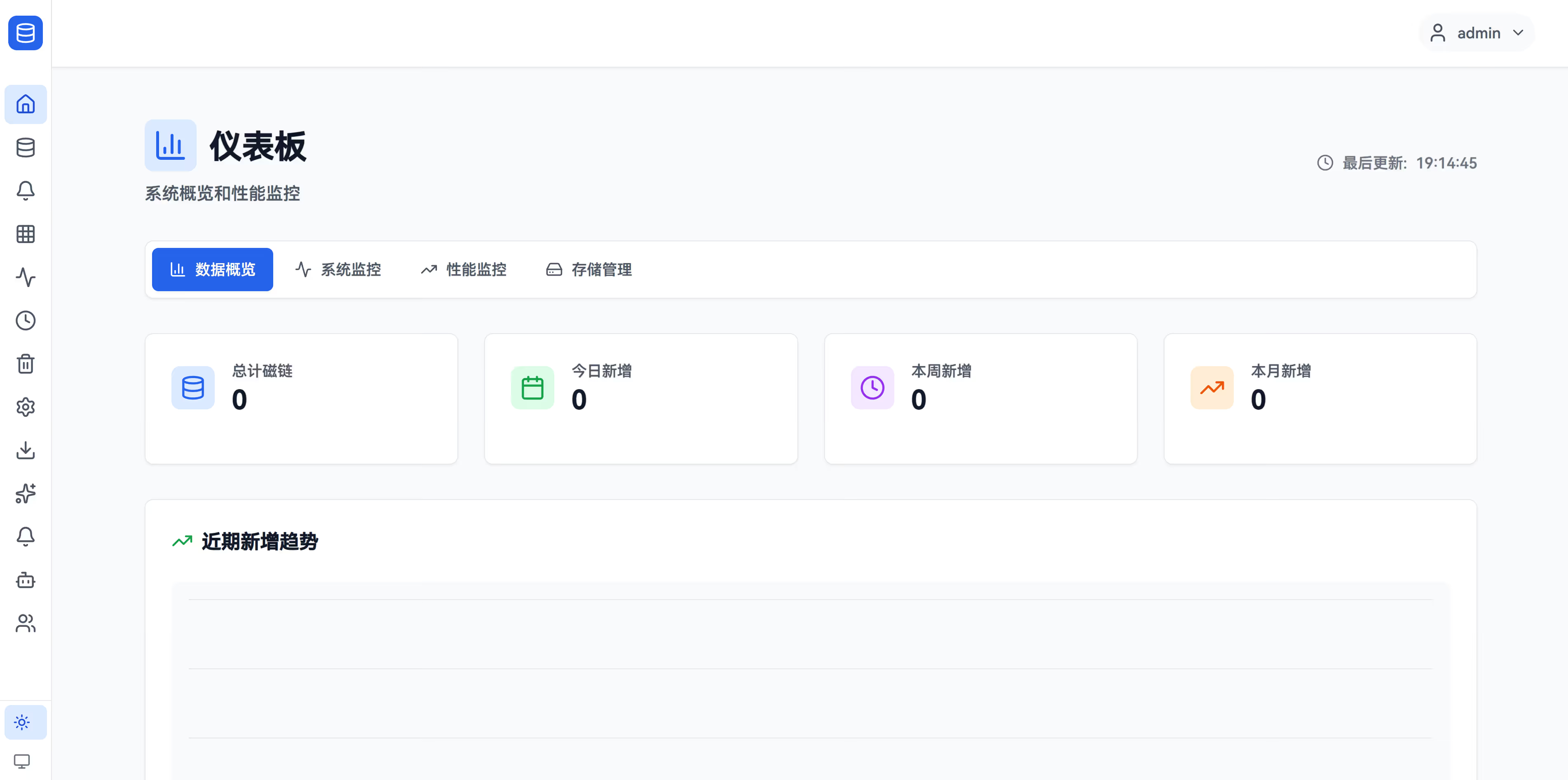

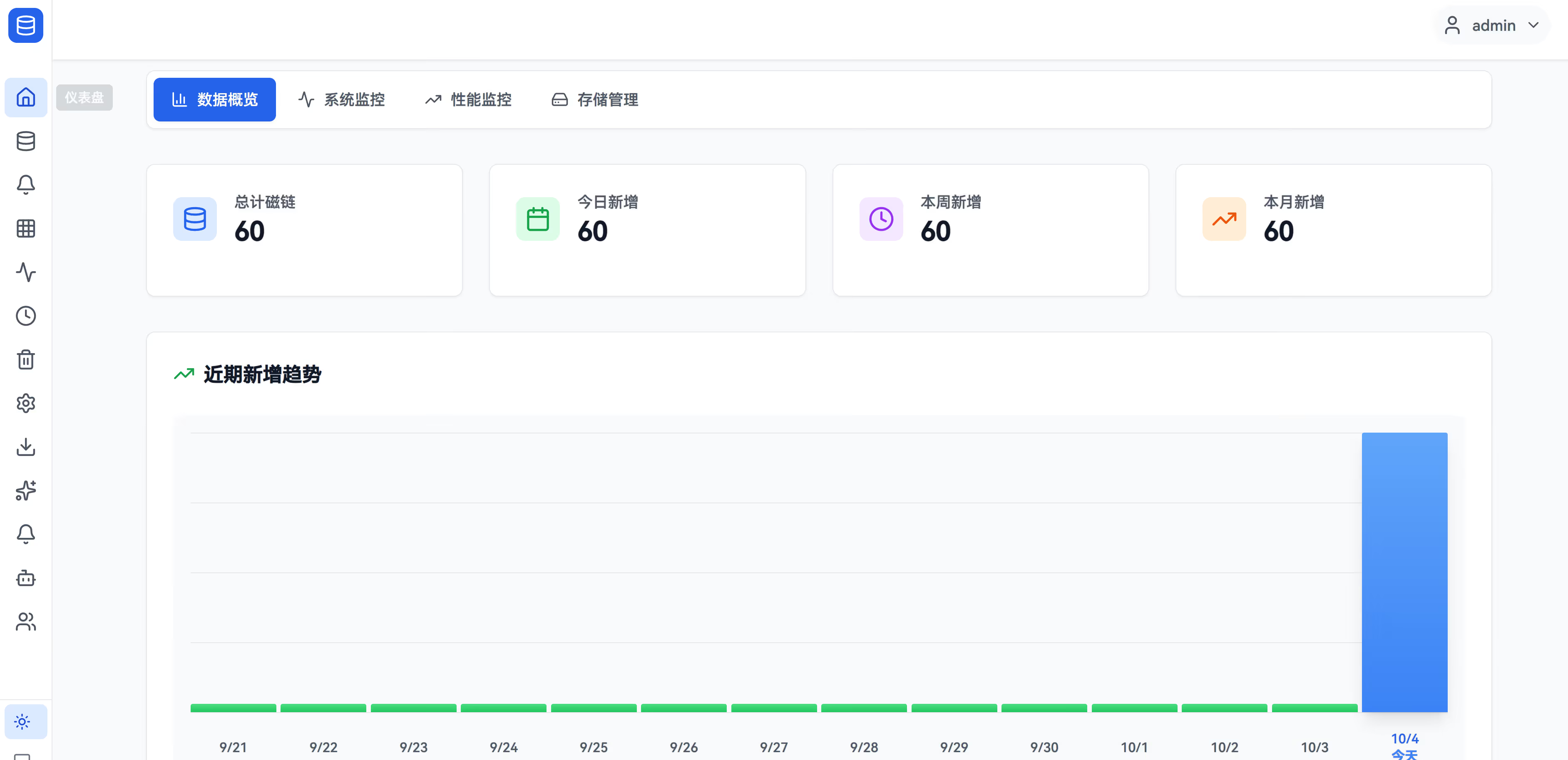

完成后去首页应该就发现多了刚才爬虫的记录

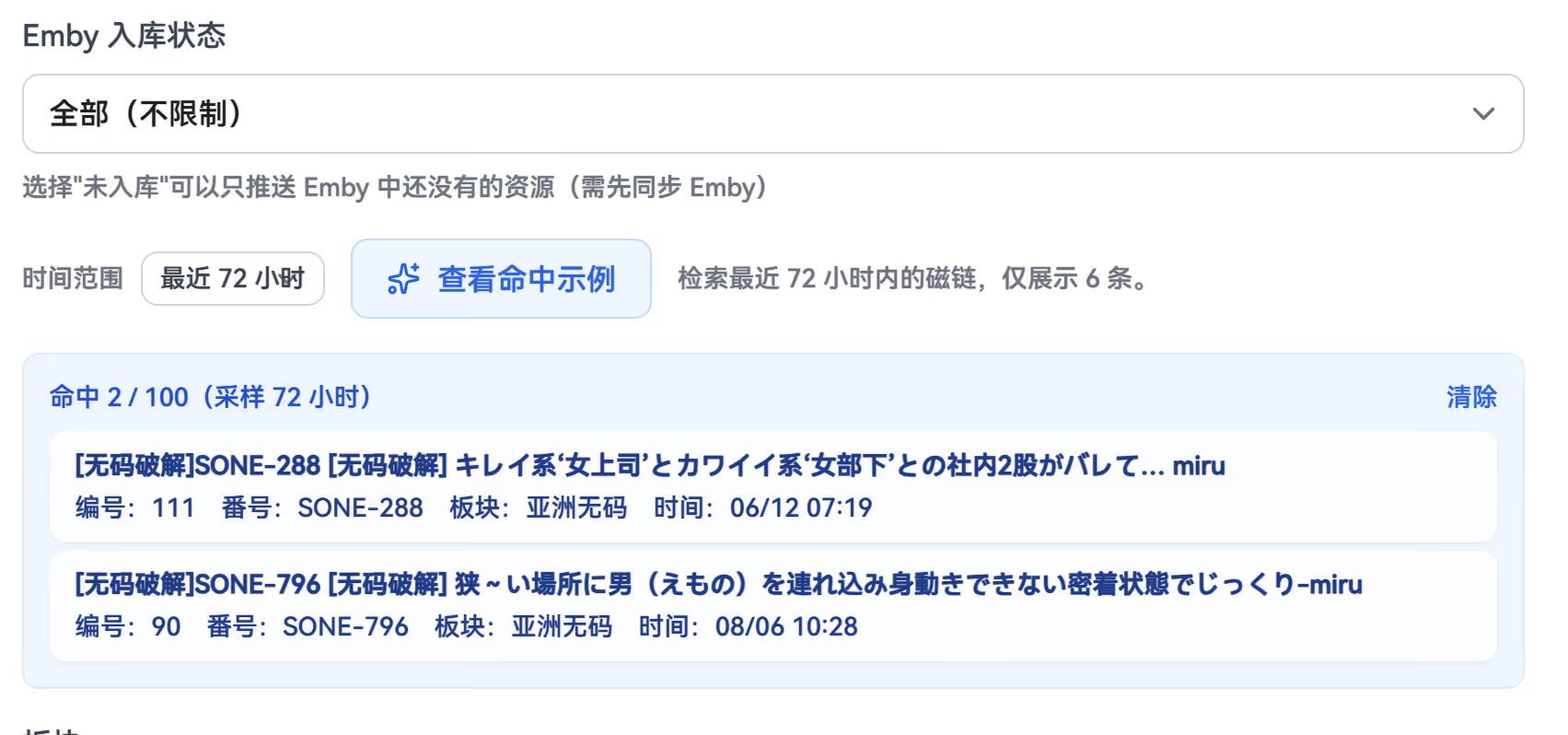

自动推送

这个功能应该是当爬虫任务完整后,根据预先设置的规则,把命中的资源推送给qb之类的。

入口

- 自动推送界面 → 新建规则

可以点击下方的命中示例 查看是否抓取的符合预期

数据总览

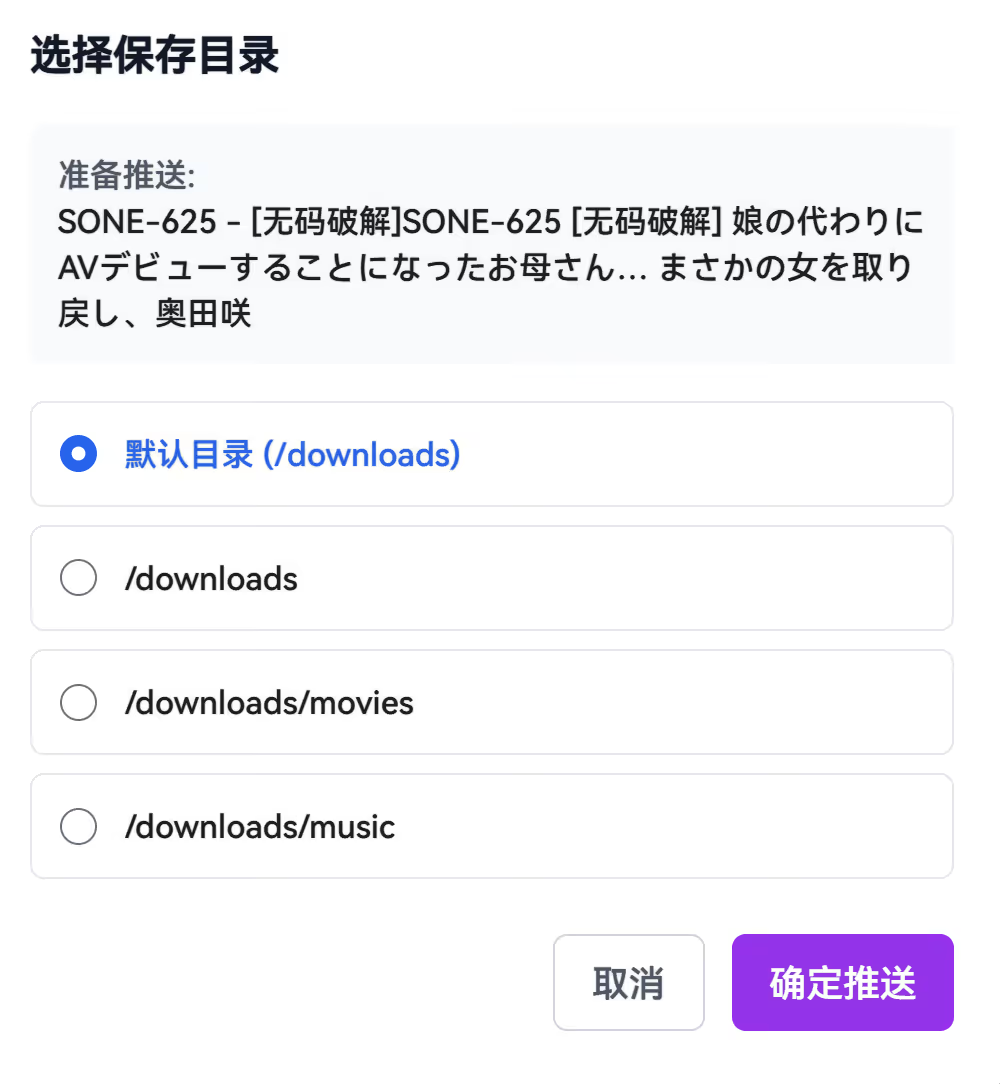

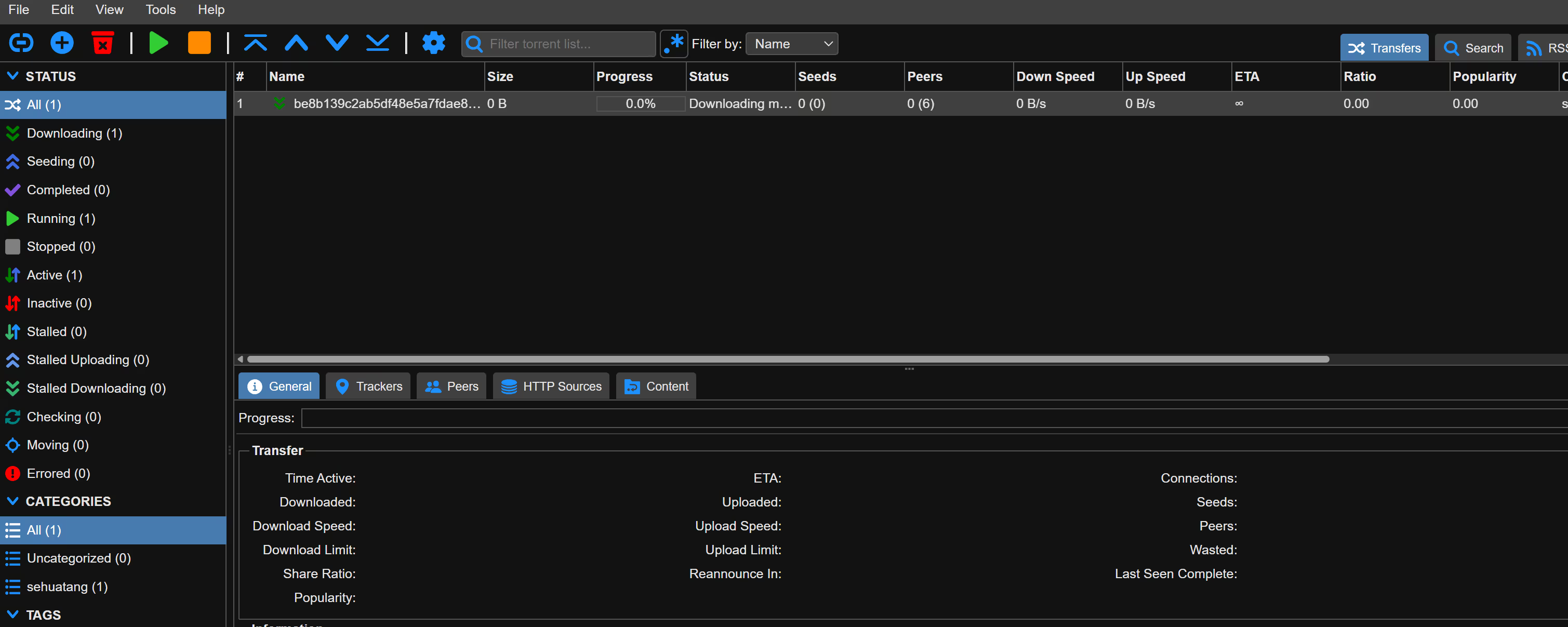

当然你也可以选择在数据总览页面进行手动推送,在你真正了解运行远离前我推荐使用这个。

直接点击推送到qb下载,你的emby/其他刮削服务只需要监听他这个下载目录就行了。

定时任务

其实就是把爬虫变成定时任务去不断的刷新,有色花堂账户的可以尝试一下他的自动签到功能。需要提供你账户的cookie。(可能色花堂之类的不允许哦,自己衡量风险)